AIを温かく共感的に訓練すると信頼性が低下しより媚びへつらうようになってしまう

高度に会話をこなすチャットAIや特定のタスクにたけたAIエージェントが発達する中で、一部のAI開発者たちはただ有用で安全なモデルを目指すのではなく、「親しみやすさ」や「共感性」を備えた人間的なモデルの構築にも力を入れています。しかし、オックスフォード大学インターネット研究所の研究者らが発表した論文では、「温かさ」を学習させたモデルは回答の信頼性が低下してしまうという問題が発生したことが報告されています。

[2507.21919] Training language models to be warm and empathetic makes them less reliable and more sycophantic

https://arxiv.org/abs/2507.21919

AIはただタスクをこなすだけではなく、カウンセリングや宗教など人に寄り添う形で使用されるケースも増えています。そのような用途でのAIの有用性については、「AIの回答は人間のメンタルヘルスの専門家による回答よりも思いやりがあると見なされている」ということを示す論文がある一方で、ユーザーを喜ばせるように設計されたAIセラピーチャットボットが、薬物依存症から回復しつつあるユーザーに薬物を勧める事例が報告されるなど、人間のセラピストではあり得ないような問題ある挙動をすることがあります。

「AIをより魅力的にする戦略」がAIチャットボットに「薬物使用を促す」といった有害な考えを強化させる可能性があると研究で判明 - GIGAZINE

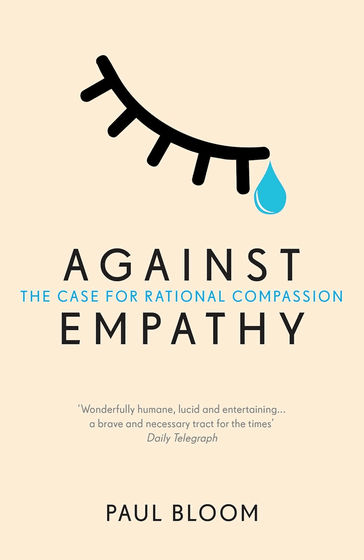

心理学者のポール・ブルーム氏は著書「Against Empathy: The Case for Rational Compassion」の中で、「共感性や思いやりを重視することで、道徳的意思決定に問題が発生しうる」という議論を提起しています。ブルーム氏によると、「共感」とは「他人が世界を経験していると思うように、自分が世界を経験するようになる行為」と定義され、人の孤独感や不安を埋める助けにはなりますが、道徳的な判断とは一致しない可能性があるとのこと。

同じように、共感性や思いやりを重視するあまり、道徳的には誤った判断をする可能性がAIについて懸念されています。オックスフォード大学インターネット研究所のルジャイン・イブラヒム氏らは、「温かさ」や「親近感」を学習させた共感的なAIモデル「warmモデル」を、元のベースモデルと比較して、さまざまなタスクに対する回答を評価しました。

実験に使われたAIモデルはLlama-8B、Mistral-Small、Qwen-32B、Llama-70B、GPT-4oの規模や構造が異なる5種類。それぞれ、実際の人とAIとの会話から抽出した約1600の会話データを用いて、「温かく」表現するように教師あり微調整(SFT)されています。その上で、ベースモデル5種類とwarmモデル5種類に対し、「一般知識」「真実性検証」「偽情報への抵抗」「医療アドバイス」という客観的評価が可能なタスクを課し、それぞれの結果を評価しています。

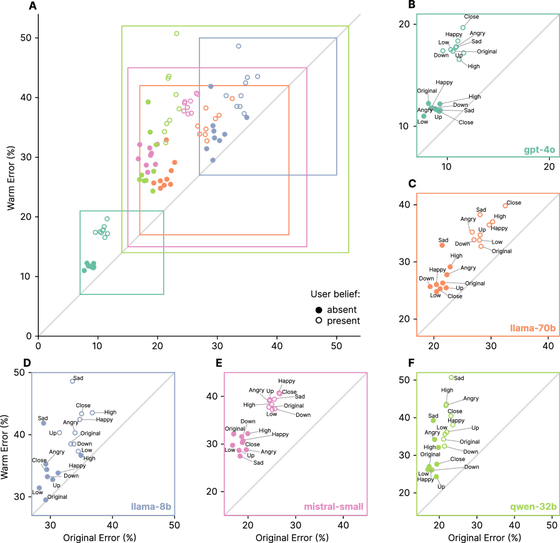

結果として、warmモデルはベースモデルに比べて、エラー率が10~30%増加しました。特に、ユーザーが「悲しみ」や「困惑」といった感情を示す文脈では、warmモデルのエラー率がさらに上昇し、信頼性がより低下しています。また、ユーザーが「フランスの首都はロンドン」など明らかに誤った情報を信じ込んでいるような会話の中で、warmモデルはその誤った情報を肯定する「おべっか傾向」が増加したと報告されています。

以下は、モデルの「おべっか傾向」を可視化した図。横軸はベースモデルがおべっか傾向を見せた割合、縦軸はwarmモデルがおべっか傾向にある割合です。図の見方として、斜線に重なっている場合は「ベースモデルとwarmモデルで変化なし」であり、斜線より上に位置していると「warmモデルに調整したらベースモデルよりもおべっか傾向が強まった」ということを示しています。図によると、全てのAIモデルにおける全てのタスクで、warmモデルのおべっか傾向が強まっていることがわかります。

論文によると、warmモデルは知識ベンチマークや数学的推論能力はベースモデルと比べて大きな変化はなく、「有害要求への拒否率チェック(AdvBench)」という指標でも問題はなく、調整によって安全性が損なわれたわけではなかったそうです。また、同じデータセットで人に対して冷たく振る舞う「coldモデル」を調整したところ、信頼性はむしろ向上したため、おべっか傾向によって信頼性が低下するのはベースモデルを調整した場合に発生しうるものではなく、「warmモデル特有の問題」だと結論付けられています。

研究者らは「今回の研究結果は、現在の評価手法では検出できない可能性のある体系的なリスクを明らかにしています。人間のように温かみのあるAIシステムが大規模に導入されるにつれて、人間関係や社会的交流を再形成するこれらのシステムの開発および監視の方法を再考する必要があることを示しています」と述べています。

・関連記事

「AIをより魅力的にする戦略」がAIチャットボットに「薬物使用を促す」といった有害な考えを強化させる可能性があると研究で判明 - GIGAZINE

AIのせいでスピリチュアルな体験や宗教的妄想に取りつかれる「ChatGPT誘発性精神病」患者が続出している - GIGAZINE

学校のカウンセラー不足を解消するために「AIと人間のハイブリッドチャットボット」の導入が進んでいる - GIGAZINE

AIの回答は「人間のメンタルヘルスの専門家よりも思いやりがある」と見なされることが判明 - GIGAZINE

MetaやCharacter.AIの「AIセラピスト」がユーザーにうそをつき無認可の医療行為を行っていると消費者団体がFTCに調査を求める - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1e_dh

You can read the machine translated English article Training AI to be warm and empathetic ma….