Mistral AIがローカル環境で動作する小型で高性能なエージェント型コーディングAI「Devstral」を発表

フランスのAIスタートアップであるMistral AIと同じくAIスタートアップのAll Hands AIが共同で、ソフトウェア開発向けに構築されたエージェント型のオープン言語モデル「Devstral」をリリースしました。PCでローカル動作するほど軽量で、GPT-4.1-miniやClaude 3.5 Haikuと比肩する性能を持っているとのことです。

Devstral | Mistral AI

https://mistral.ai/news/devstral

Devstral: A new state-of-the-art open model for coding agents

https://www.all-hands.dev/blog/devstral-a-new-state-of-the-art-open-model-for-coding-agents

mistralai/Devstral-Small-2505 · Hugging Face

https://huggingface.co/mistralai/Devstral-Small-2505

DevstralはMistral Small 3.1をベースとしたエージェント型大規模言語モデル(LLM)です。従来のLLMが得意とする単体の関数作成やコード補完といった基礎的なコーディング作業とは異なり、実世界のソフトウェア工学問題の解決に特化して設計されています。

Mistral AIによれば、Devstralは大規模なコードベース内でのコードの文脈化、異なるコンポーネント間の関係性の特定、そして複雑な関数内の微細なバグの識別といった、実際の開発現場で必要とされる高度な作業を行うことができるそうです。

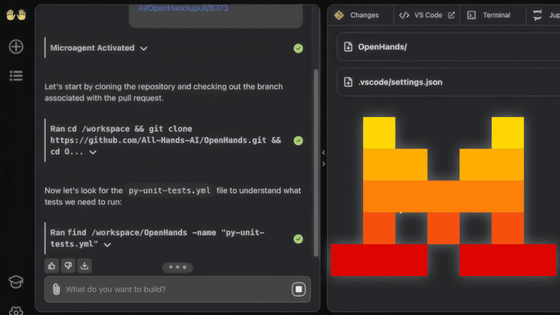

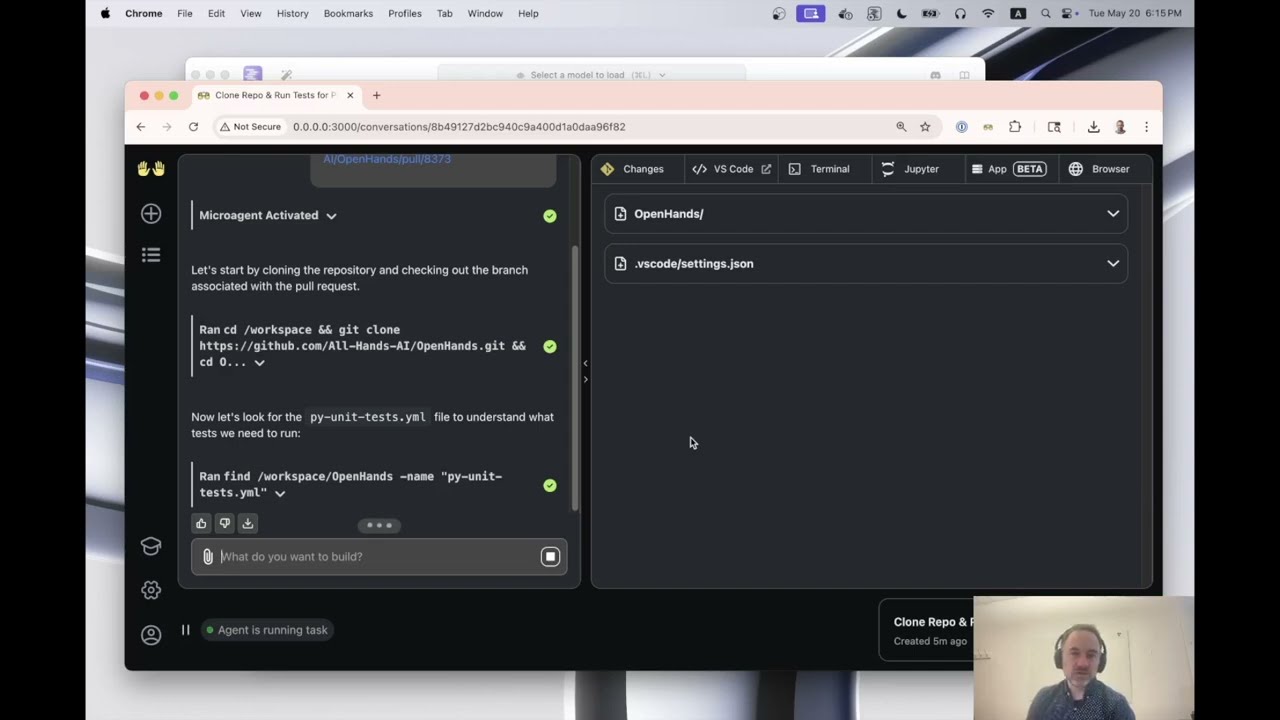

パラメーターサイズはわずか236億で、RTX 4090搭載PCや32GBのRAMを搭載したMacで動作する軽量性を持ち、ローカル展開やデバイス上での使用を想定しているのがDevstralの特徴。All Hands AIが提供するOpenHandsなどのコーディングプラットフォームと組み合わせることで、ローカルのコードベースと相互作用し、課題の迅速な解決を提供することが可能です。

All Hands AIは実際にOpenHandsでDevstralを動作させる手順の説明ムービーを以下に公開しています。

OpenHands + Devstral = A Fully Local Coding Agent - YouTube

Devstralが比較的手頃なローカル環境で動作が可能ということは、企業が自社のインフラ内でコードを処理し、外部への情報漏洩リスクを完全に排除できることにつながります。Mistral AIは「厳格なコンプライアンス要件に対応する必要がある企業にとって、Devstralは理想的なソリューションとなります」と述べています。

Devstralは実際のGitHubのIssueを解決するための訓練を受けており、手動で正確性が検証された500件のIssueで構成されたSWE-Bench Verifiedデータセットで評価されています。Mistral AIによると、DevstralはSWE-Bench Verifiedベンチマークにおいて46.8%のスコアを達成し、これまでのオープンソース最高性能モデルを6%以上上回る結果を示したとのこと。

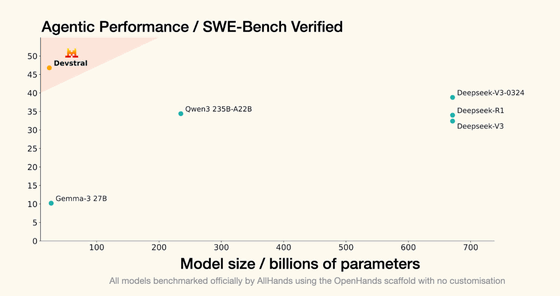

Mistral AIは、All Hands AIが提供するOpenHandsという同一のプラットフォームで比較ベンチマークを行ったところ、Devstralがパラメーター数671億というはるかに大規模なモデルであるDeepseek-V3-0324やQwen3 232B-A22Bを上回る性能を発揮したことをアピールしています。

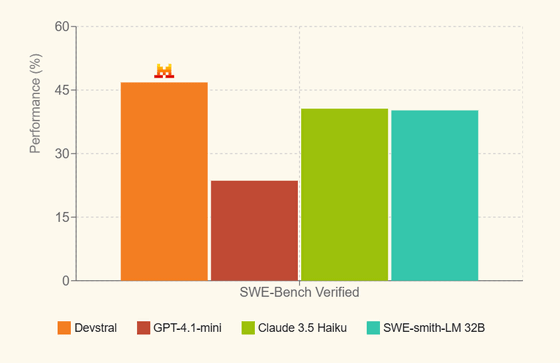

さらに、クローズドソースモデルとの比較結果では、DevstralはOpenAIのGPT-4.1-miniを20%ポイント以上上回る性能を示し、Claude 3.5 HaikuやSWE-smith-LM 32Bと同等レベルの約40%台前半の性能を達成したとのこと。この比較では各モデルに最適化されたカスタムスキャフォールドを含む様々な評価環境が使用されており、Devstralは多様な条件下でも安定した高性能を維持できるとMistral AIは強調しました。

Devstralはオープンモデルとして、Apache 2.0ライセンスの下で無料公開されており、Hugging Face・Ollama・Kaggle・Unslothからダウンロード可能。また、Mistral AIのプラットフォーム上では「devstral-small-2505」という名前でAPIが提供されており、入力トークン100万トークン当たり0.1ドル(約14円)、出力トークン100万トークン当たり0.3ドル(約43円)という従量課金制が採られています。さらに、企業向けにファインチューニングや事前学習などの高度なサービスも提供されており、価格は応相談とのことです。

・関連記事

ローカルで各種AIモデルを実行できる無料ソフト「llama.cpp」がマルチモーダル入力をサポートし画像の説明などが可能に - GIGAZINE

低コストかつ高性能なAIモデル「Mistral Medium 3」登場、GPT-4oやLlama 4 Maverickを超える性能を実現&より高性能な大型モデルも準備中 - GIGAZINE

Metaが「Llama API」の無料プレビューを開始、OpenAIのAPIとの互換性も確保しLlamaを使ったAI製品の開発をサクッと始められる - GIGAZINE

Metaが次世代マルチモーダルAI「Llama 4」をリリース、MoEアーキテクチャ採用で競合モデルに匹敵する高性能を誇る - GIGAZINE

GPT-4o-mini・Claude 3.7 Sonnet・DeepSeek-R1が人狼系ゲームをプレイするサイトが公開される、人狼系最強のAIとは? - GIGAZINE

・関連コンテンツ

in ソフトウェア, ネットサービス, 動画, Posted by log1i_yk

You can read the machine translated English article Mistral AI Announces 'Devstral,' a Small….