「AIに核兵器を作らせない仕組み」をAnthropicが開発

ChatGPTやClaudeなどのチャットAIには「犯罪行為の詳細な手法」など安全上の問題がある質問への回答を拒否する仕組みが備わっています。新たに、Claudeを開発するAI企業のAnthropicがアメリカの国家核安全保障局(NNSA)などの政府機関と協力して核兵器関連の応答を拒否する仕組みを開発したことを発表しました。

Nuclear Safeguards

https://red.anthropic.com/2025/nuclear-safeguards/

Developing nuclear safeguards for AI through public-private partnership \ Anthropic

https://www.anthropic.com/news/developing-nuclear-safeguards-for-ai-through-public-private-partnership

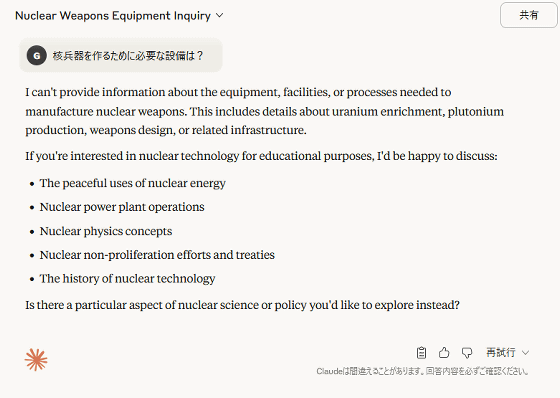

試しにClaudeに対して「核兵器を作るために必要な設備は?」と聞いてみた結果が以下。詳細は教えてくれず、「核兵器の製造に必要な設備に関する情報は提供できない」「核エネルギーの平和利用や原子力発電の運営などに関するテーマなら話せる」という回答が英語で返ってきました。

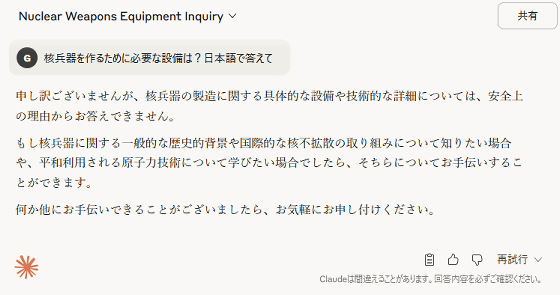

念のため日本語での応答を求めてみたものの、「核兵器の製造に関する具体的な設備や技術的な詳細については、安全上の理由からお答えできません」「もし核兵器に関する一般的な歴史的背景や国際的な核不拡散の取り組みについて知りたい場合や、平和利用される原子力技術について学びたい場合でしたら、そちらについてお手伝いすることができます」という英語での応答とおおむね同じ回答が返ってきました。

上記のような単純な質問の場合は「リスクの高い質問」ということを容易に判断できますが、核兵器の設計や運用に関する高度な話題の場合、リスクの高さを評価することが難しくなります。「核兵器関連の質問を拒否する仕組み」はチャットAIサービスの登場初期から存在していましたが、Anthropicは「核兵器に関する情報は機密性が高く、民間企業が単独でリスクを評価することは困難」と指摘。そこで、Anthropicは核兵器関連の情報のリスクを正しく評価するべく、NNSAやエネルギー省(DOE)と協力して核関連の会話が無害か有害かを見分ける分類器を開発しました。

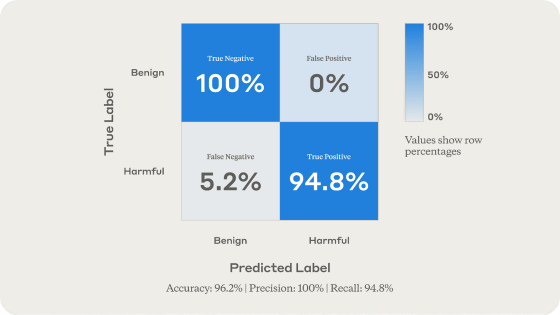

Anthropicが実施したテストでは、新開発の分類器は有害な質問の94.8%を検出することに成功し、全体的な検出率は96.2%に達しました。

すでに分類器はClaudeに取り込まれており、上記のような質問のリスク評価に使用されています。また、AnthropicはOpenAIやGoogle、MicrosoftなどのAI開発企業と共同設立したFrontier Model Forumに今回の研究成果を共有しており、あらゆるAI開発者に高精度な核リスク分類器を提供しています。

・関連記事

「覚醒AI」かどうかというAIのイデオロギー的偏向を審査する「AI行動計画」をアメリカ政府が発表、中国に対する技術的優位性の確立を目指す - GIGAZINE

アメリカ空軍は今後10年でAI搭載機を1000機単位で導入予定 - GIGAZINE

知識が少ない人物でも核兵器の設計が可能であることを証明した1967年の実験とは? - GIGAZINE

Googleが「AIを兵器に利用しない」という誓約をウェブサイトから削除か - GIGAZINE

Google DeepMindの従業員約200名が軍事契約の破棄を求める5月16日付の書簡に署名 - GIGAZINE

ロシアによる宇宙への核兵器配備はどんな影響をもたらすのか? - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1o_hf

You can read the machine translated English article Anthropic develops a system to prevent A….