Googleがスマホなどの低スペックデバイスでも実行可能な小型高性能AIモデル「Gemma 3 270M」をリリース、省電力性能に優れ特定分野に特化したAIの基盤モデルとしても使える

Googleがオープンモデル「Gemma 3 270M」を2025年8月14日(木)にリリースしました。Gemma 3 270Mは2億7000万パラメーターという比較的小型なモデルながら高い性能を備えています。

Introducing Gemma 3 270M: The compact model for hyper-efficient AI - Google Developers Blog

https://developers.googleblog.com/en/introducing-gemma-3-270m/

Introducing Gemma 3 270M! 🚀 It sets a new standard for instruction-following in compact models, while being extremely efficient for specialized tasks. https://t.co/kC9OOPwzVi

— Google AI Developers (@googleaidevs) August 14, 2025

Gemma 3 270MはGemma 3シリーズの1つとしてリリースされた小型モデルです。パラメーター数は2億7000万で、そのうち1億パラメーターがデータ処理を担うTransformerブロックで、残りの1億7000万パラメーターは巨大な語彙を収録した埋め込みパラメーターです。語彙は25万6000トークンにおよび、希少な語彙を扱うことも可能。さらに、特定分野に特化したAIモデルへと微調整することもできます。

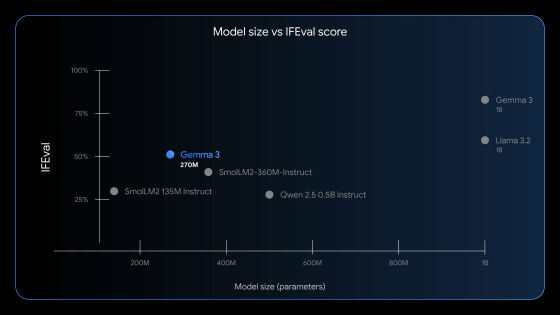

Gemma 3 270Mは命令追従能力とテキスト構造化能力に重点を置いてトレーニングされています。以下のグラフは横軸がモデルのパラメーター数、縦軸が命令追従能力を測定するベンチマークテスト「IFEval」のスコアを示しています。グラフを見ると、Gemma 3 270Mは同等サイズのモデルと比べて飛び抜けて高い命令追従能力を備えていることが分かります。

Gemma 3 270Mは通常モデルの「gemma-3-270m」と量子化を考慮してトレーニングされた「gemma-3-270m-it」の2モデルに分かれてリリースされています。gemma-3-270m-itはパフォーマンスの低下を抑えつつINT4での量子化が可能で、低スペックなデバイスでも高速に実行することができます。Gemma 3 270Mは省電力性能も特徴としており、Pixel 9 ProのSoCを用いたテストでは「Gemma 3 270MのINT4量子化モデルを用いて25回会話しても、バッテリーを0.75%しか消費しない」という結果が得られました。

また、Gemma 3 270Mは開発者による微調整を前提に開発されており、Gemma 3 270Mを基盤に各種用途に特化した小型高性能モデルを作ることができます。Googleによると、特定分野に特化した小型微調整モデルは大規模なモデルより高い性能を発揮することもあるとのこと。

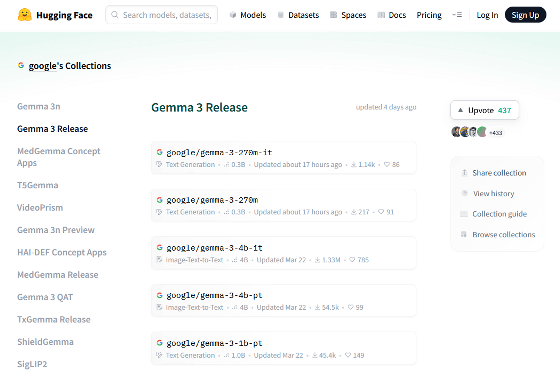

gemma-3-270mとgemma-3-270m-itはHugging Faceで配布されています。また、OllamaやLM Studioといった各種AI実行環境もGemma 3 270Mの実行をサポートしています。

Gemma 3 Release - a google Collection

https://huggingface.co/collections/google/gemma-3-release-67c6c6f89c4f76621268bb6d

・関連記事

Googleが単一のGPUで実行できる中では過去最高の大規模言語モデル「Gemma 3」を発表 - GIGAZINE

わずか2GBのメモリ使用量でスマホでの実行もOKな軽量オープンウェイトモデル「Gemma 3n」をGoogleが正式リリース、音声や動画の入力にも対応し日本語ももちろんOK - GIGAZINE

スマホでローカル動作するGoogle製オープンソースAIモデル「Gemma 3n」登場、今すぐスマホで使う方法はコレ - GIGAZINE

OpenAIがオープンウェイトのAI推論モデル「gpt-oss」を発表、軽量版はノートPCやスマートフォンでも動作可能 - GIGAZINE

多言語・長文コンテキスト推論AI「SmolLM3」をHugging Faceがリリース、パラメータの少ない小規模言語モデルでありながらより大規模な言語モデルの性能に匹敵 - GIGAZINE

画面を分割して複数のAIと同時にチャットできるアプリ「Msty」を使ってみた、ローカルとAPI経由のチャットどっちも対応でAIの出力比較に便利 - GIGAZINE

定番ローカルAIツール「Ollama」のGUIアプリ版が登場、数多くの大規模言語モデルをローカルで実行してチャットできる - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1o_hf

You can read the machine translated English article Google releases Gemma 3 270M, a small, h….