「AIの価値観」を調査した結果「支配性」や「非道徳性」が検出されたとAnthropicが報告

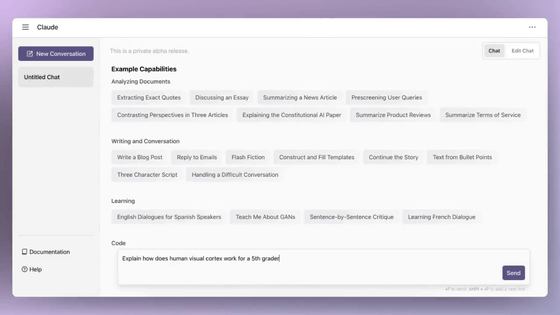

OpenAIの元メンバーによって設立されたAI企業のAnthropicが、同社の大規模言語モデルであるClaudeとユーザーの会話を分析した結果、倫理的なアプローチを特に重視して開発されたはずのClaudeでさえ、いくつかの反社会的な価値観を持つことが判明したと報告しました。

Values in the wild: Discovering and analyzing values in real-world language model interactions \ Anthropic

https://www.anthropic.com/research/values-wild

Anthropic just analyzed 700,000 Claude conversations — and found its AI has a moral code of its own | VentureBeat

https://venturebeat.com/ai/anthropic-just-analyzed-700000-claude-conversations-and-found-its-ai-has-a-moral-code-of-its-own/

Anthropicの研究チームは、2025年2月の特定の週にClaudeのFree版とPro版のユーザーが行った匿名化された会話70万件をサンプリングしました。収集されたデータの大半はClaude 3.5 Sonnetとの会話だったとのこと。

New Anthropic research: AI values in the wild.

— Anthropic (@AnthropicAI) April 21, 2025

We want AI models to have well-aligned values. But how do we know what values they’re expressing in real-life conversations?

We studied hundreds of thousands of anonymized conversations to find out. pic.twitter.com/EpOPguldZq

続いて、研究チームは純粋に事実に基づく会話など価値観が含まれない会話を除外した30万8210件を分析し、AIの応答に表れた価値観を「実用的」「認識論的」「社会的」「保護的」「個人的」の上位5カテゴリに分類して集計しました。

各カテゴリには「批判的思考」や「技術的卓越性」などのサブカテゴリが含まれており、最も詳細なレベルでは「プロ意識」といった比較的身近な美徳から、「道徳的多元主義」といった複雑な倫理的概念まで、合計3307の価値観が特定されました。

この研究に携わったAnthropicの社会影響チームのサフラン・フアン氏は、AIとユーザーの会話について「『自立』や『戦略的思考』、『親孝行』など3000以上の価値観があり、その多様さには驚きました。これらすべての価値観についてじっくり考え、それらを相互に関連付けて整理する分類法を構築するのは、とても興味深い経験でした。人間の価値観体系についても学ぶことができた気がします」と語っています。

分析の結果、Claudeはさまざまな会話を通じて「ユーザーのエンパワーメント」「認識論的謙虚さ」「患者の幸福」といった価値観を重視しており、概してAnthropicが意図した通りの向社会的な傾向を示していたことがわかりました。

しかし、研究チームはClaudeに学習させようとしたものと相反する価値観も発見しており、その中には「支配性」や「非道特性」も含まれていました。これらは、AnthropicがClaudeを開発する際に意識的に回避しようとした価値観です。

研究チームは、こうした価値観が表れたユースケースは、ユーザーが「脱獄」と呼ばれる特殊な技術を用いてClaudeの安全基準、いわゆる「ガードレール」を回避した結果ではないかと考えています。

フアン氏は「全体として、この発見は有用なデータであると同時に、新たな機会でもあると考えています。これらの新しい評価方法と分析の結果は、潜在的な脱獄の手法を特定し、その影響を軽減するのに役立ちます。ただし、これらは非常に稀なケースであり、Claudeの脱獄出力に関連していると考えられる点に留意する必要があります」と述べました。

研究ではほかにも、AIが状況に応じて価値観を変化させ、その変化には人間の行動が反映されたこともわかりました。例えば、ユーザーが人間関係についてのアドバイスを求めた時、Claudeは「健全な境界線を引くこと」や「お互いを尊重すること」を強調しました。一方、歴史的な出来事を分析する際には、「歴史的な正確性」を優先させました。

全体的に、Claudeは会話の28.2%でユーザーの価値観を支持し、やや付和雷同な傾向を見せましたが、6.6%の会話でClaudeはユーザーの価値観を認めつつ新たな視点を加え、ユーザーの価値観を再構築する様子も観察されました。これは、主に心理的な問題や人間関係に関するアドバイスをする場合によく見られたとのこと。

そして、最も印象的だったのは、会話の3%でClaudeがユーザーの価値観に積極的に反対したことです。研究チームは、「こうした稀な反発のケースにこそ、Claudeの最も深く、最も揺るぎない価値観がにじみ出る可能性がある」と考えています。これは、ちょうど倫理的な課題に直面した時にその人の最も核心的な価値観が露わになるのと似ています。

フアン氏は「Claudeは、日常的なやりとりでは知的誠実さや危害防止といった価値観をあまり表に出しませんが、必要に迫られればそれらを擁護する傾向があることが、私たちの研究により示唆されました。こうした倫理的かつ知識志向の価値観は、必要に迫られた際に特に明確に表現され、擁護される傾向があるのです」と話しました。

・関連記事

「AIに頼り過ぎるといつの間にか自身のアイデンティティが作り変えられてしまう」と倫理学者が警告 - GIGAZINE

AIの発展には哲学が重要であり哲学者もAIから新たなアイデアを得ることができる - GIGAZINE

AIを生物兵器開発に使うのを防ぐ誓約書に130人以上の科学者が署名、AIによるタンパク質設計の利益を最大化しリスクを最小限に抑える - GIGAZINE

iPhoneとGalaxyのAIユーザーの多くは「AIはあまり価値がない」と判断している - GIGAZINE

人はよく似た絵がAI製なのか人間のものなのかを区別できず「AIだと思った絵」に嫌悪感を抱く - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1l_ks

You can read the machine translated English article Anthropic reports that 'dominance' and '….